A nagy teljesítményű mesterséges intelligencia modellek fejlesztéséhez szükséges adatbányászat során az olyan technológiai óriások, mint például az OpenAI, a rendelkezésre álló webtartalom szinte egészét összegyűjtötték.

A Wall Street Journal arra figyelmeztet, hogy a jó minőségű szöveges adatok (tudományos publikációk, könyvek, Wikipédia szócikkek) az elkövetkezendő másfél évben teljesen elfogyhatnak. A vállalatok így rá vannak kényszerülve, hogy új módszereket találjanak az adatszerzésre.

Úgy tanulnak, mint a gyerekek

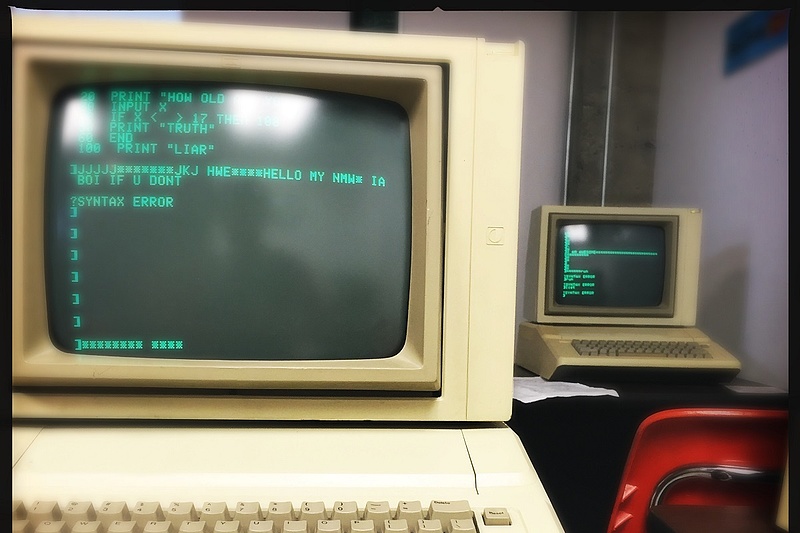

A mesterséges intelligencia modellek tanítása sok hasonlóságot mutat a gyermekek tanításával. Minél többet olvasnak ezek a modellek, annál okosabbak lesznek.

A fejlesztéshez tehát rengeteg megbízható, szöveges információra van szüksége ezeknek a cégeknek. Az összegyűjtött adatokat ezek után megtisztítják, feldolgozzák, majd kisebb egységekre, szavakra, kifejezésekre, mondatokra bontják.

A nyelvi AI modellek ezután mintázatokat keresnek a szövegben, amelyek segítségével felismerik a nyelvi struktúrákat, így megtanulják a szavak és a kifejezések közti összefüggéseket. A modellek pedig minél több szöveget elemeznek, annál pontosabban találják meg a helyes nyelvi szerkezeteket, így érthető miért van ekkora igény a jó minőségű, hiteles forrásból származó információra.

A vezető nyelvi modelleket eddig körülbelül háromezer milliárd szó segítségével tanították be. Hogy kontextusba helyezzük: az Oxford egyetemi könyvtárában, ahol 1602 óta gyűjtenek könyveket, ennek a szómennyiségek nagyjából a fele elérhető.

Új forrás: videóból szöveg

A tech cégek, hogy elkerüljék növekedési terveik visszaszorítását, kénytelenek új módszerekkel adatokhoz jutni, ezek közül pedig több a jogi szürke zónába eshet – írja a New York Times.

Az OpenAI kifejlesztett egy olyan alkalmazást, ami YouTube videók hanganyagából készít írott szöveges tartalmat. Ezzel a cég új adatforráshoz juthatott, ám szerzői jogi akadályokba ütközhetnek.

Viszont a Google, a YouTube anyavállalata eddig nem lépett semmit az ügyben. Hogy miért? A New York Times értesülései szerint a Google ugyanezt csinálja, hogy a saját AI modelljeit fejleszthesse. Ez a lépés pedig potenciálisan sértheti a tartalomgyártók szerzői jogait.

Közben Mark Zuckerberg sem tétlenkedik. Az adathiány lassan olyan méreteket ölt, hogy a Facebook anyavállalata, a Meta fontolóra vette a Simon & Schuster kiadó felvásárlását, hogy a könyveiben található információhoz jogszerűen hozzájusson.

Sy Damle, a Szilícium-völgy ismert szerzői jogi ügyvédje szerint a nyelvi AI modellek gyakorlati megvalósításának egyetlen módja, ha hatalmas mennyiségű adaton taníthatók anélkül, hogy azt licenszelni kellene. A jogász szerint akkora adathalmazról van szó, hogy még a kollektív licenc sem működhet.

Kreatív megoldás: szintetikus információ

A szintetikus élelmiszerek után jöhet az új őrület, a szintetikus adat. Mivel az ember által készített internetes tartalmak nagy részét már elfogyasztották a mesterséges intelligencia modellek, a cégek a szintetikus információ ötletével álltak elő. Ez azt jelenti, hogy mesterséges intelligenciát fognak használni szövegírásra, hogy aztán ezeken az új adatokon fejlesszék ugyanazt az AI-t, mint ami azokat előállította.

A megoldással az lehet a fő probléma, hogy azok a modellek, amelyek a saját maguk által generált szintetikus adaton edződnek, könnyen olyan negatív ciklusba kerülhetnek, amiben a saját hibáikat, tévedéseiket erősítik meg.

Az OpenAI ennek megelőzésére azzal kísérletezik, hogy két különböző modell tanítja egymást, azaz az első modell által generált szintetikus adatot a második modell tanításában használják fel. A kutatók egyelőre nem értenek egyet a módszer megbízhatóságában, a cég vezetője, Sam Altman szerint azonban minden rendben lesz.

Kövesse az Economx.hu-t!

Értesüljön időben a legfontosabb gazdasági és pénzügyi hírekről! Kövessen minket Facebookon, Instagramon vagy iratkozzon fel Google News és YouTube-csatornánkra!

Legolvasottabb

Leállt az M3-as metró

Mintegy 1,7 milliárd forintot tüntetett el az emberek pénzéből a fideszes cég

Új, digitális aranybányát találtak a hackerek: magyarok adatai is veszélyben vannak

Háborús pszichózis: már egy magyarral sem hajlandó kezet fogni az ukrán teniszező

Fertőzésgyanú egy iskolában, tömeges szűrés kezdődött

Váratlan dolog derült ki az állampapírokról

Nem lesz kormányváltás? Két hónappal a választások előtt derült ki: a magyarokat nem érdekli a szavazás!

Félig üresen kong a Barátság-vezeték, már csak mi vásárlunk

Brutális magyarázat! Az államtitkár kegyetlen ítéletet mondott a magyar szegénységről, Pintér Sándor hallgatott